Revue de Recherche

MedGemma 1.5 et MedASR : Google redéfinit l’IA médicale open source et multimodale

MedGemma 1.5 et MedASR de Google, une révolution open source pour l’IA médicale.

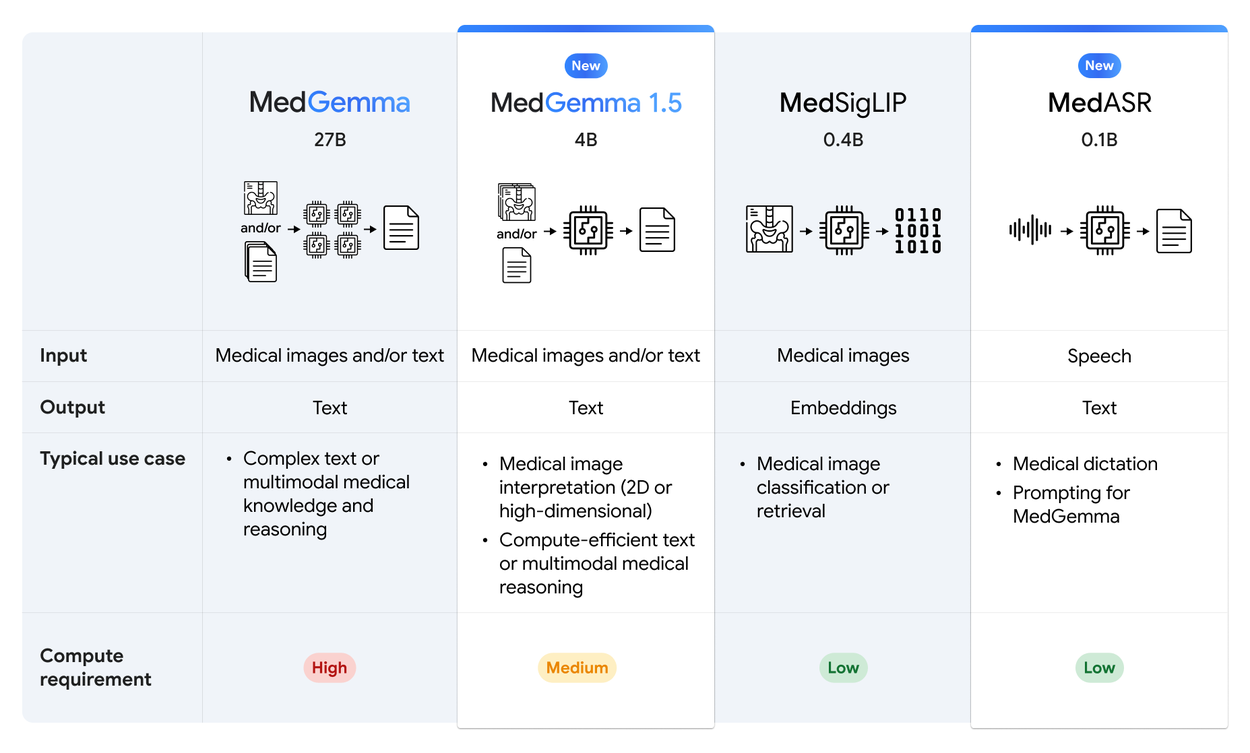

Le secteur de la santé vit une mutation technologique sans précédent. Alors que nous entamons l’année 2026, Google Research vient de frapper un grand coup dans l’univers de l’open source avec la mise à jour majeure de sa suite d’IA médicale. Si vous êtes développeur, data scientist ou simplement passionné par l’intersection entre le code et la médecine, ce qui suit va grandement vous intéresser. Nous décortiquons pour vous l’arrivée de MedGemma 1.5 et du tout nouveau MedASR.

Une nouvelle ère pour l’IA en santé

L’intelligence artificielle ne se contente plus de promesses théoriques dans le domaine médical, elle entre dans une phase d’industrialisation et de démocratisation sans précédent. Avec cette nouvelle vague d’annonces, Google confirme sa volonté de fournir des briques logicielles robustes et ouvertes. Cette stratégie vise à combler le fossé entre la puissance de calcul des géants de la Tech et les besoins concrets des praticiens sur le terrain, en offrant aux développeurs les outils nécessaires pour bâtir la médecine de demain.

Accélération de l’adoption technologique

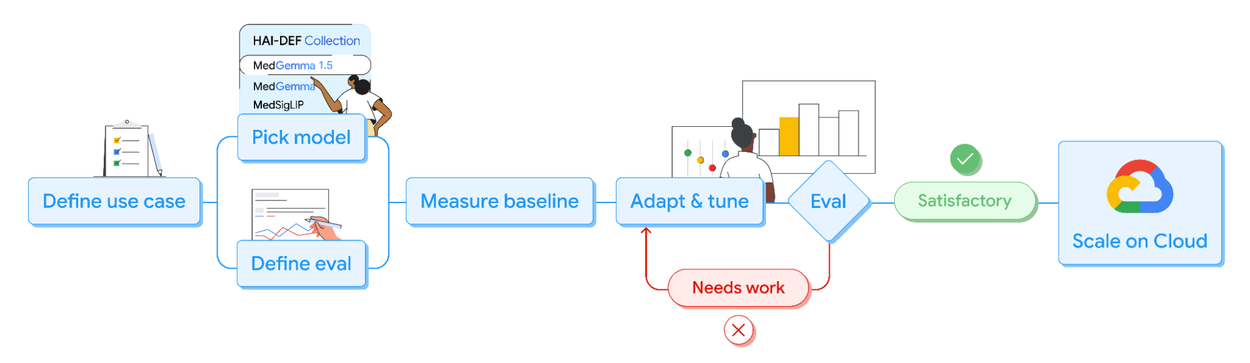

L’intelligence artificielle ne se contente plus de faire des vagues dans la tech, elle submerge positivement le secteur médical. Selon les dernières données, l’industrie de la santé adopte actuellement l’IA à un rythme deux fois supérieur à celui de l’économie globale. Pour accompagner cette transformation, Google a consolidé sa stratégie autour du programme Health AI Developer Foundations (HAI-DEF).

L’objectif est clair, ne pas garder les outils les plus puissants enfermés dans des laboratoires de recherche, mais les mettre entre les mains de la communauté. Les modèles comme MedGemma ne sont pas conçus comme des produits finis et rigides, mais comme des briques fondamentales (des « points de départ ») que les développeurs peuvent évaluer, adapter et spécialiser pour des cas d’usage cliniques précis.

Architecture unifiée et accessibilité

Ce qui rend cette annonce particulièrement excitante pour nous, développeurs, c’est l’accent mis sur l’accessibilité technique. Google a compris que la puissance brute ne sert à rien si elle est impossible à déployer. Ces nouveaux modèles sont immédiatement disponibles via des plateformes que nous utilisons quotidiennement, comme Hugging Face et Kaggle, mais aussi intégrés pour une mise à l’échelle industrielle sur Google Cloud via Vertex AI.

Cette approche « Developer-first » permet de réduire drastiquement la friction entre la recherche académique de pointe et le développement d’applications concrètes, qu’il s’agisse de startups MedTech ou de grands centres hospitaliers cherchant à moderniser leur infrastructure logicielle.

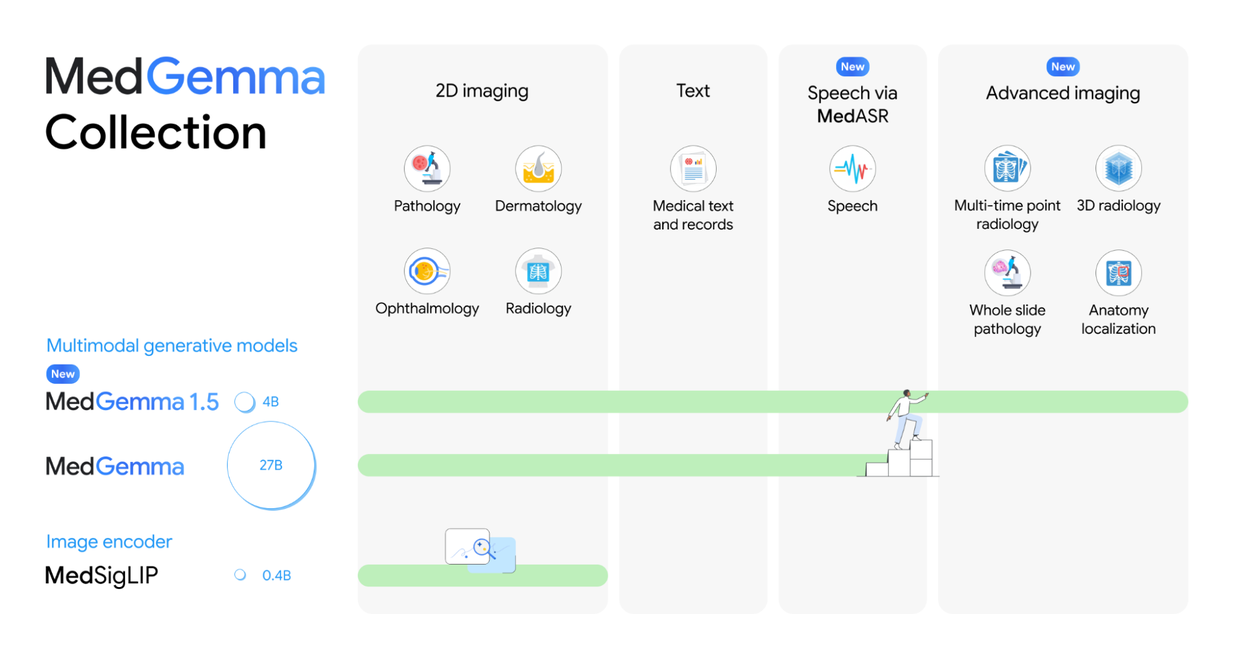

MedGemma 1.5 : Au-delà de l’Image 2D

Si la version précédente de MedGemma avait déjà prouvé son efficacité sur l’analyse de radiographies standards, la médecine moderne est bien trop complexe pour se limiter à des images statiques en deux dimensions. Le corps humain est un volume dynamique qui évolue dans le temps. C’est précisément ce défi que relève MedGemma 1.5, franchir la barrière de la « vraie » multimodalité en intégrant la compréhension de l’espace (3D) et du temps (analyse temporelle), rapprochant ainsi l’IA de la vision réelle d’un radiologue expert.

Gestion de l’imagerie volumétrique 3D

La véritable rupture technologique de MedGemma 1.5 réside dans sa capacité à « voir » en trois dimensions. Jusqu’à présent, la plupart des modèles multimodaux se contentaient d’analyser des images planes, comme des radiographies classiques. MedGemma 1.5 brise cette barrière en intégrant nativement la prise en charge de l’imagerie médicale de haute dimension, notamment les tomodensitogrammes (CT scans) et l’imagerie par résonance magnétique (IRM).

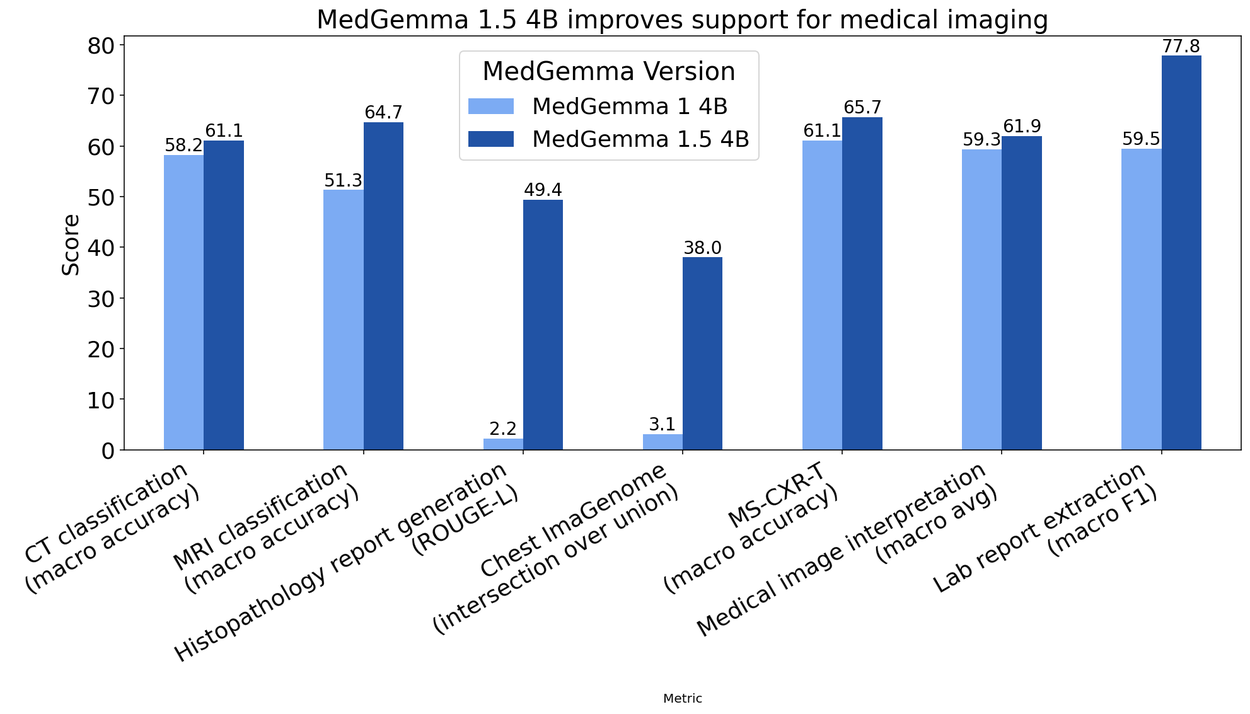

Concrètement, comment cela fonctionne-t-il sous le capot ? Le modèle ne regarde pas juste une image, mais ingère plusieurs « tranches » (slices) ou patchs d’un volume 3D, accompagnés d’un prompt textuel décrivant la tâche. Cela permet à l’IA de comprendre la structure spatiale d’un organe ou d’une lésion, là où une simple image 2D perdrait toute notion de profondeur. Sur les benchmarks internes, cette approche a permis d’augmenter la précision de 14% sur la classification des résultats d’IRM par rapport à la version précédente. C’est un saut qualitatif immense pour l’aide au diagnostic complexe.

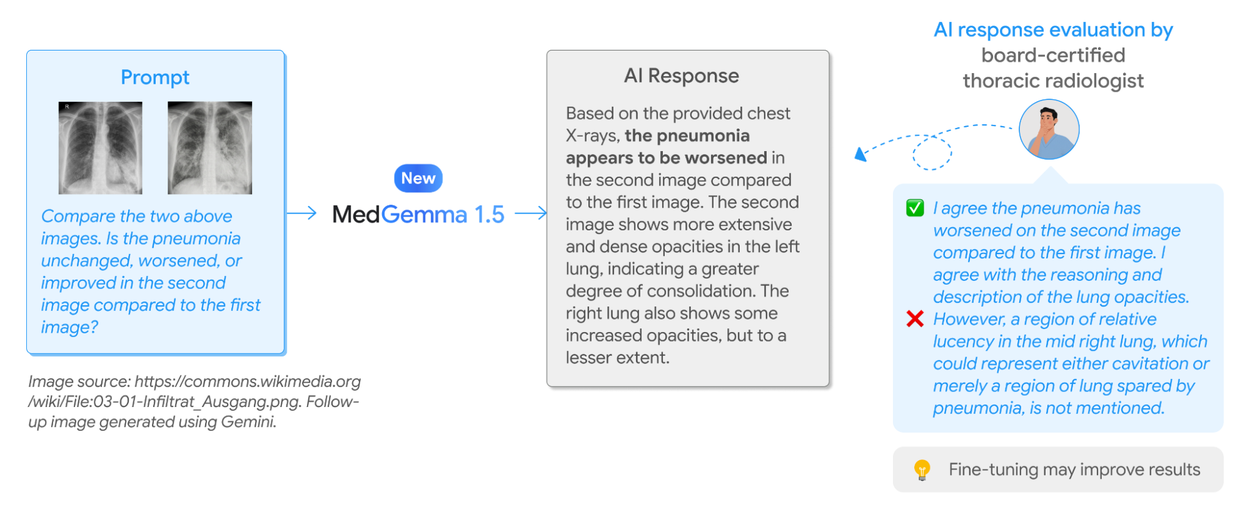

Analyse longitudinale et temporelle

En médecine, l’état d’un patient à un instant T est important, mais son évolution l’est encore plus. C’est ici qu’intervient l’autre grande nouveauté, l’imagerie médicale longitudinale. MedGemma 1.5 est désormais capable d’effectuer une revue de séries temporelles, par exemple en comparant des radiographies thoraciques prises à des moments différents.

L’IA peut ainsi détecter si une pathologie (comme une pneumonie ou une masse) s’est aggravée, est restée stable ou s’est résorbée. Dans les tests effectués, cette capacité à contextualiser l’image dans le temps a permis une amélioration de 5% de la précision sur le benchmark MS-CXR-T. Pour le développeur, cela ouvre la porte à la création d’assistants capables de pré-rédiger des rapports de suivi, soulignant automatiquement les changements subtils qu’un œil humain fatigué pourrait manquer après des heures de garde.

Optimisation du modèle 4B

Il est souvent tentant de penser que « plus c’est gros, mieux c’est » en matière de LLM. Pourtant, Google a fait le choix stratégique de publier une version optimisée de 4 milliards de paramètres (4B). Pourquoi est-ce une excellente nouvelle ? Parce qu’un modèle de cette taille offre un équilibre parfait entre performance et efficacité de calcul.

Ce modèle est suffisamment léger pour tourner sur des infrastructures modestes, voire potentiellement en mode « hors ligne » (edge computing), ce qui est crucial pour la confidentialité des données hospitalières ou pour les zones à faible connectivité. Malgré sa taille contenue, MedGemma 1.5 4B surpasse son prédécesseur non seulement en imagerie, mais aussi en raisonnement textuel pur, avec un gain de 5% sur le benchmark MedQA et de 22% sur la réponse aux questions basées sur les dossiers de santé électroniques (EHRQA).

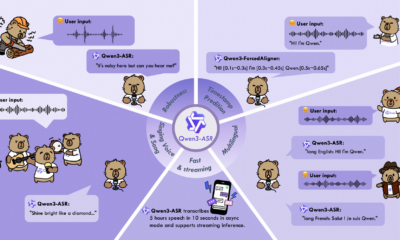

MedASR : La reconnaissance vocale spécialisée

Dans le tumulte d’un service hospitalier, le clavier est souvent un frein à l’efficacité. La voix reste l’interface la plus naturelle et la plus rapide pour un médecin, que ce soit pour dicter un compte-rendu ou échanger avec un patient. Cependant, les modèles de reconnaissance vocale grand public échouent trop souvent face à la complexité du jargon médical. Pour pallier ce manque, Google introduit une pièce maîtresse dans son écosystème, un modèle dédié capable de décrypter le vocabulaire clinique avec une bonne précision.

Transcription médicale de précision

Le texte est roi, mais la parole est le mode de communication naturel des soignants. Google introduit donc MedASR, un modèle de reconnaissance automatique de la parole (Speech-to-Text) spécifiquement affiné pour le domaine médical. Si vous avez déjà essayé d’utiliser des modèles généralistes pour transcrire une dictée médicale remplie de termes latins et d’abréviations techniques, vous savez que le résultat est souvent catastrophique.

Les chiffres parlent d’eux-mêmes, comparé à Whisper (le modèle généraliste de référence d’OpenAI), MedASR réduit le taux d’erreur de mots (WER) de 58% sur les dictées de radiographies thoraciques (5.2% contre 12.5%). Sur un benchmark interne couvrant diverses spécialités et accents, la réduction d’erreurs atteint même 82%. Pour un développeur construisant une application de dictée pour médecins, passer à MedASR est une nécessité pour atteindre un niveau de fiabilité acceptable.

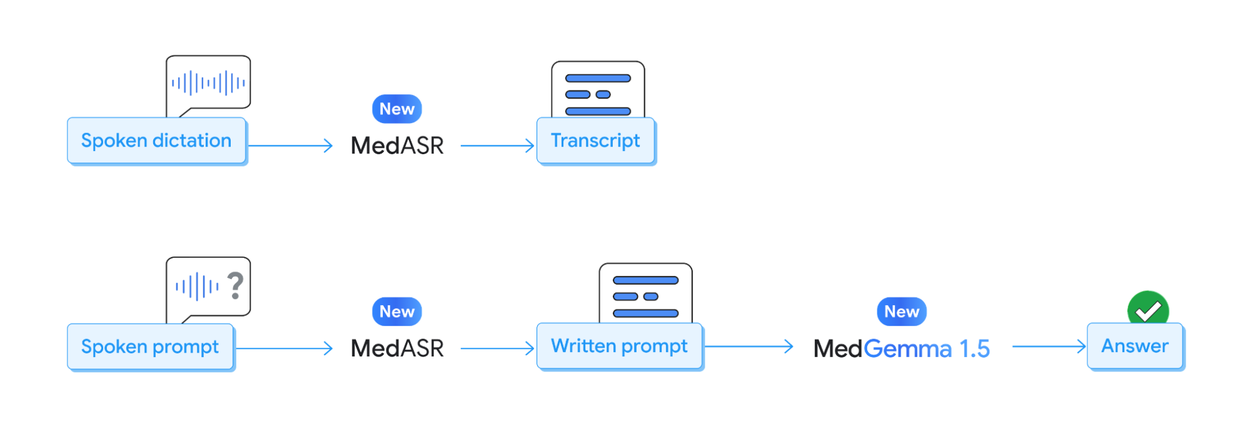

Synergie multimodale audio-texte

La puissance de cet écosystème se révèle lorsque l’on combine les briques entre elles. MedASR, en plus d’être un outil de transcription passive, il devient une interface d’entrée pour MedGemma. Imaginez un flux de travail où le radiologue dicte ses observations ou pose une question complexe à voix haute.

MedASR convertit cette parole en texte structuré avec une haute fidélité, qui est ensuite immédiatement ingéré par MedGemma pour le raisonnement clinique ou l’analyse d’image associée. Google fournit d’ailleurs des « notebooks » tutoriels pour aider les développeurs à créer ces pipelines multimodaux. C’est un pas de géant vers des assistants IA avec lesquels on peut converser naturellement, fluidifiant considérablement le travail administratif et clinique.

Initiatives communautaires et compétition

Pour stimuler encore plus l’innovation, Google ne se contente pas de donner le code. Ils lancent le MedGemma Impact Challenge, un hackathon hébergé sur Kaggle doté de 100 000 $ de prix. C’est un appel direct à notre communauté, prenez ces outils, soyez créatifs et construisez les solutions de demain. Que vous soyez un vétéran du code ou un étudiant curieux, c’est l’occasion idéale de mettre les mains dans le cambouis et de tester ces nouvelles capacités sur des problèmes réels.

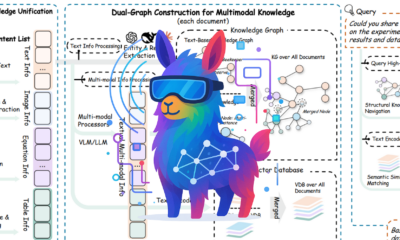

Écosystème, Intégration et Impact

Un modèle d’IA, aussi puissant soit-il, ne sert à rien s’il reste isolé dans un laboratoire. La véritable valeur de MedGemma et MedASR réside dans leur capacité à s’intégrer dans les workflows existants des développeurs et des hôpitaux. De l’infrastructure Cloud aux formats de fichiers standards de l’imagerie médicale, Google a pensé ces outils pour qu’ils soient déployables, adaptables et scalables.

Déploiement technique et support DICOM

Pour que ces modèles soient utiles, ils doivent s’intégrer aux standards existants. Google a fait un effort notable pour inclure un support complet du format DICOM (Digital Imaging and Communications in Medicine), la norme universelle pour le stockage et la transmission des images médicales.

Les applications déployées sur Google Cloud bénéficient désormais de cette compatibilité native, facilitant l’ingestion des données issues des scanners et IRM sans nécessiter de conversion fastidieuse ou de perte de métadonnées. De plus, les développeurs peuvent affiner (fine-tuner) ces modèles sur leurs propres datasets via des techniques comme LoRA (Low-Rank Adaptation), rendant l’adaptation à des spécialités de niche (comme la dermatologie ou l’ophtalmologie) à la fois rapide et peu coûteuse en ressources de calcul.

Exemples d’applications concrètes

Loin de la théorie, ces modèles sont déjà en action. Le rapport de Google met en lumière le travail de Qmed Asia, une startup malaisienne, qui a adapté MedGemma pour créer une interface conversationnelle naviguant dans plus de 150 directives de pratique clinique. Les médecins peuvent désormais interroger ces bases de connaissances complexes en langage naturel pour obtenir des aides à la décision instantanées.

Cadre éthique et limitations techniques

L’intégration de l’IA dans le parcours de soin est une avancée fascinante, mais elle s’accompagne d’une responsabilité immense. Contrairement à la génération de code ou d’images artistiques, une erreur ici peut avoir des conséquences humaines critiques. Il est donc indispensable d’aborder ces technologies avec lucidité, en comprenant leurs garde-fous, la gestion rigoureuse des données sensibles et la place centrale que doit conserver l’humain dans la validation des résultats.

Protection et confidentialité des données

En tant que techniciens, nous devons aussi être garants de l’éthique. Google insiste sur le fait que les modèles ont été entraînés sur un mélange de données publiques et privées rigoureusement désidentifiées. La protection de la vie privée des patients reste la priorité absolue. L’utilisation de ces modèles nécessite de maintenir ces standards élevés, en s’assurant que toute application dérivée respecte les protocoles de sécurité et d’anonymisation en vigueur.

Nécessité de validation clinique

Enfin, il est impératif de rappeler le disclaimer essentiel accompagnant ces technologies. MedGemma et MedASR sont des outils d’assistance, et non des remplaçants. Ils sont fournis comme des points de départ pour le développement et ne doivent pas être utilisés pour le diagnostic clinique direct sans validation appropriée.

Les « hallucinations » ou erreurs restent possibles. Tout système basé sur ces modèles doit inclure une boucle de vérification humaine (Human-in-the-loop). L’IA propose, le médecin dispose. C’est en gardant cette philosophie à l’esprit que nous pourrons construire des outils puissants, sûrs et véritablement utiles pour la médecine de demain.

Yang, L., & al. (2025). MedGemma technical report. arXiv. https://arxiv.org/abs/2507.05201