Intelligence Artificielle

Comprendre l’architecture Mixture of Experts (MoE)

L’essor de l’intelligence artificielle (IA) a permis le développement de modèles de plus en plus complexes, capables de résoudre des problèmes variés et sophistiqués. Parmi ces avancées technologiques, l’architecture Mixture of Experts (MoE) est une innovation majeure qui a révolutionné la conception des réseaux neuronaux. Contrairement aux architectures traditionnelles où un seul modèle central gère toutes les tâches, MoE repose sur une approche collaborative entre plusieurs sous-modèles spécialisés, appelés « experts ».

Cette méthode permet non seulement d’améliorer les performances, mais aussi de réduire considérablement les coûts liés à l’entraînement d’un modèle d’IA. Dans cet article, nous allons explorer les origines de cette architecture, son fonctionnement, ses différences par rapport aux autres réseaux neuronaux, ainsi que ses nombreux avantages.

Quelle est l’origine du Mixture of Experts (MoE) ?

Le concept de Mixture of Experts trouve ses racines dans les années 1990, lorsque Jerome H. Friedman, Ronald A. Kohavi et Richard D. Yun ont introduit cette idée dans leur travail pionnier. À l’époque, ils cherchaient à contourner les limites des réseaux neuronaux conventionnels, notamment leur manque de flexibilité pour traiter des données hétérogènes ou complexes. L’idée principale était de diviser les tâches entre plusieurs experts spécialisés, chacun capable de se concentrer sur une partie spécifique du problème. Ces experts sont ensuite combinés par un mécanisme appelé « gating network« , qui décide quel expert est le mieux adapté pour traiter une donnée particulière.

Cette approche a rapidement attiré l’attention des chercheurs en IA, car elle offrait une solution élégante pour améliorer les performances des modèles sans nécessiter une augmentation massive des ressources matérielles. Depuis lors, de nombreuses entreprises et laboratoires, comme Deepseek, ont adopté et perfectionné cette architecture, la rendant adaptée aux défis modernes du traitement des grandes masses de données.

Les fondations théoriques

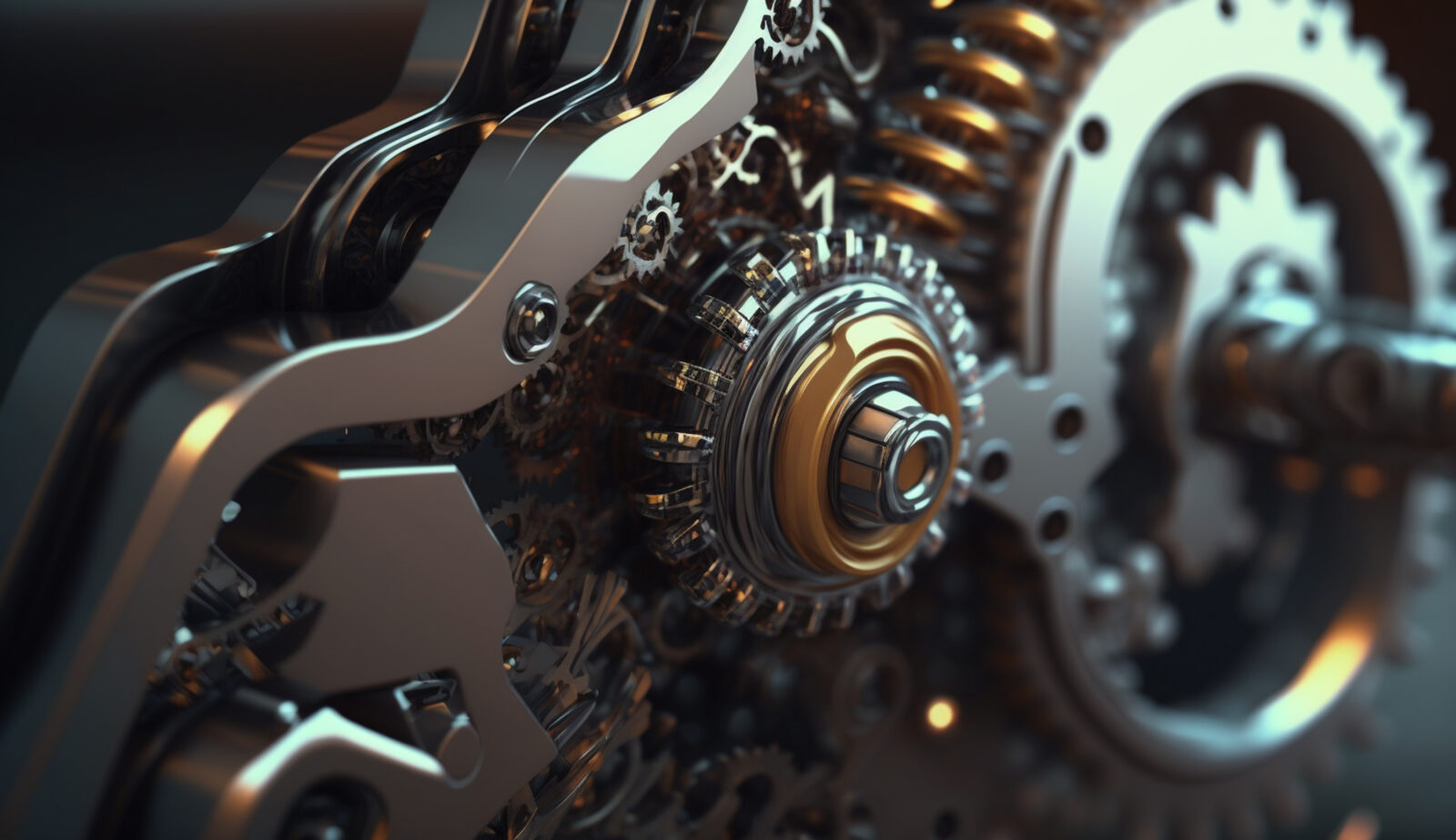

L’objectif principal de MoE est de diviser pour régner. Plutôt que de concevoir un unique réseau neuronal massif capable de tout faire, MoE segmente les problèmes en sous-problèmes plus petits, attribuant chaque sous-problème à un expert spécialisé. Cela permet de réduire la complexité globale du modèle, tout en augmentant sa capacité à apprendre efficacement des patterns spécifiques.

Qu’est-ce que l’architecture Mixture of Experts et en quoi diffère-t-elle des autres architectures de réseaux neuronaux ?

L’architecture Mixture of Experts (MoE) est une approche innovante qui s’éloigne des méthodes classiques utilisées dans les réseaux neuronaux. Alors que les réseaux neuronaux standards tentent de capturer toutes les caractéristiques pertinentes dans une seule structure, MoE fragmente ce processus en plusieurs parties indépendantes, chacune étant responsable d’une fraction spécifique des données.

Une alternative aux réseaux neuronaux massifs

Les réseaux neuronaux conventionnels, tels que ceux basés sur des couches entièrement connectées ou des architectures CNN/Transformer, sont souvent très volumineux et consomment beaucoup de ressources lors de l’entraînement d’un modèle d’IA. Par exemple, un grand Transformer peut contenir des milliards de paramètres, nécessitant des infrastructures coûteuses pour être entraînées. En revanche, MoE divise ces paramètres entre plusieurs experts, ce qui permet de limiter l’utilisation des ressources pour chaque sous-modèle.

De plus, contrairement aux réseaux neuronaux standard, où chaque couche traite toutes les entrées de manière uniforme, MoE utilise un système de sélection dynamique pour activer uniquement les experts pertinents pour une donnée. Ce mécanisme assure que chaque expert ne soit sollicité que lorsqu’il est nécessaire, optimisant ainsi l’utilisation des ressources.

Fonctionnement l’architecture Mixture of Experts ?

Pour comprendre comment fonctionne MoE, il est important de décomposer ses composants principaux : les experts, le gating network et le processus de combinaison.

Les experts, des sous-modèles spécialisés

Dans une architecture MoE, chaque expert est un sous-modèle de réseau neuronal conçu pour exceller dans une tâche spécifique. Par exemple, un expert pourrait être entraîné pour détecter des motifs dans des images, tandis qu’un autre serait spécialisé dans la compréhension du langage naturel. Ces experts fonctionnent en parallèle, permettant au modèle global de couvrir une large gamme de capacités tout en restant performant dans chaque domaine.

Le gating network, un coordinateur intelligent

Le rôle du gating network est crucial dans MoE. Il agit comme un chef d’orchestre, déterminant quels experts doitent être activés pour une donnée particulière. Ce choix est basé sur des critères tels que la similarité entre la donnée et les types de données que chaque expert a appris à manipuler. Grâce à ce système, MoE peut adapter ses réponses en temps réel, garantissant une grande flexibilité.

La combinaison finale, intégration des résultats

Une fois que les experts ont traité leurs parties respectives des données, leurs sorties sont combinées pour produire une réponse finale. Cette étape peut être réalisée de différentes manières, selon l’application spécifique, mais elle vise toujours à tirer parti des forces de chaque expert pour générer une prédiction optimale.

Les avantages de l’approche Mixture of Experts par rapport aux réseaux conventionnels

L’architecture Mixture of Experts (MoE) présente plusieurs avantages significatifs par rapport aux réseaux neuronaux conventionnels. Voici quelques-uns des bénéfices les plus marquants :

1. Efficiences accrues grâce à une utilisation ciblée des ressources

En activant uniquement les experts nécessaires pour une donnée, MoE minimise l’utilisation des ressources informatiques. Cela permet de former des modèles plus grands et plus performants sans avoir besoin d’infrastructures extrêmement coûteuses. Cet aspect est particulièrement important pour des projets comme ceux menés par DeepSeek, où l’efficacité énergétique est essentielle.

2. Meilleures performances grâce à la spécialisation

Chaque expert dans MoE est spécialisé dans une tâche précise, ce qui lui permet d’atteindre des niveaux de performance supérieurs à ceux d’un modèle généraliste. Par exemple, un expert dédié à la reconnaissance vocale sera bien meilleur dans ce domaine que n’importe quel modèle polyvalent. En combinant les forces de multiples experts, MoE peut surpasser les réseaux neuronaux standards dans une variété de tâches.

3. Adaptabilité aux besoins changeants

MoE est extrêmement flexible et peut être facilement adapté à de nouveaux types de données ou de tâches. Si un nouveau type de problème émerge, il suffit d’ajouter un nouvel expert spécialisé dans ce domaine, sans avoir besoin de reconstruire l’ensemble du modèle. Cette modularité fait de MoE une solution idéale pour les environnements en évolution rapide.

L’essentiel à retenir sur l’architecture MoE

L’architecture Mixture of Experts (MoE) représente une avancée majeure dans le domaine des réseaux neuronaux et de l’apprentissage automatique. En divisant les tâches entre plusieurs experts spécialisés et en utilisant un gating network pour coordonner leurs efforts, MoE offre des performances exceptionnelles tout en minimisant les coûts associés à l’entraînement d’un modèle d’IA.

Avec des applications dans des domaines variés, de la santé à la robotique en passant par la finance, MoE continue d’inspirer de nouvelles recherches et innovations. Grâce à des initiatives comme celles de DeepSeek, cette architecture devient de plus en plus accessible et puissante, promettant de transformer encore davantage le paysage de l’intelligence artificielle dans les années à venir.