Algorithme

Traitement de Langage Naturel (NLP) : Comment il fonctionne ?

Avec l’explosion des données textuelles sur Internet et les progrès de l’intelligence artificielle, apprendre à comprendre le traitement de langage naturel (NLP) devient essentiel pour saisir la manière dont les machines interagissent avec la langue humaine. Que ce soit pour des assistants vocaux comme Alexa, des chatbots ou des systèmes de traduction automatique, le NLP est au cœur des technologies numériques modernes. Dans cet article, nous allons explorer ce qu’est le traitement de langage naturel, comment il fonctionne et quelles sont les bases pour se lancer dans ce domaine.

Traitement de langage naturel (NLP), qu’est-ce que c’est ?

Le traitement de langage naturel (ou NLP pour Natural Language Processing) est une branche de l’intelligence artificielle qui permet aux machines de comprendre, d’interpréter et de générer du langage humain. Il utilise une combinaison de linguistique, de statistiques et de machine learning pour faire interagir les ordinateurs avec le langage naturel écrit ou parlé. Grâce au NLP, les intelligences artificielles, comme ChatGPT, parviennent à interpréter des requêtes complexes, à répondre de manière fluide ou encore à traduire des documents d’une langue à l’autre.

L’utilité du NLP réside dans son pouvoir de transformer des données textuelles en informations exploitables et de révolutionner des secteurs comme la santé, le commerce et l’éducation. En facilitant l’accès à des connaissances complexes et en automatisant des tâches chronophages (comme le tri des emails ou l’analyse de sentiments dans les réseaux sociaux), le NLP aide les entreprises et les individus à gagner en efficacité.

Comment fonctionne le NLP ?

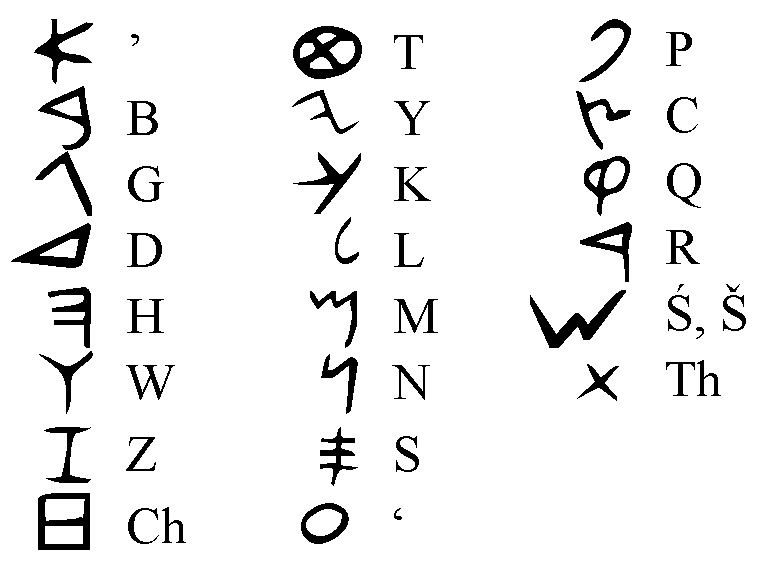

Comprendre le traitement du langage naturel (NLP) nécessite de se pencher sur ses différentes étapes fonctionnelles. Un pipeline typique de NLP commence par le prétraitement du texte, qui prépare les données textuelles brutes pour l’analyse. Cette étape inclut la tokenisation, qui divise le texte en unités plus petites comme les mots ou les phrases, la mise en minuscules pour normaliser le texte, la suppression des mots vides (comme « et » ou « le »), et la lemmatisation, qui réduit les mots à leur forme de base. Ces actions visent à nettoyer et à structurer les données textuelles, rendant ainsi les informations plus faciles à traiter par les algorithmes de machine learning.

Une fois le texte prétraité, l’étape suivante est l’extraction de caractéristiques, où le texte est converti en représentations numériques que les modèles de machine learning peuvent analyser. Des techniques telles que le Bag of Words, le TF-IDF, et les plongements lexicaux (comme Word2Vec et GloVe) sont utilisées pour transformer les mots en vecteurs de caractéristiques. Ensuite, l’analyse de texte intervient, impliquant l’application de divers algorithmes pour interpréter et extraire des informations pertinentes. Cette phase peut inclure l’étiquetage grammatical, la reconnaissance d’entités nommées, l’analyse des dépendances syntaxiques, et la détection des sentiments, permettant ainsi de comprendre le contexte et les intentions derrière le texte.

Enfin, le processus de NLP se conclut par l’entraînement du modèle et le post-traitement. Les données transformées sont utilisées pour entraîner des modèles de machine learning, qui apprennent à partir des exemples présents dans les données d’entraînement pour prédire ou générer des résultats à partir de nouvelles données. Une fois le modèle formé, les résultats qu’il fournit sont évalués et ajustés pour améliorer leur précision et leur pertinence. Des métriques telles que la précision, le rappel et la F-mesure sont souvent utilisées pour mesurer la performance des modèles NLP. Ce cycle d’entraînement et d’évaluation permet d’optimiser continuellement les modèles, assurant ainsi leur efficacité et leur fiabilité dans l’interprétation des données textuelles.

Quels sont les modèles qui peuvent faire du NLP ?

Comprendre le traitement du langage naturel (NLP) implique de se familiariser avec divers modèles de machine learning et de deep learning. Parmi eux, les réseaux de neurones Transformers ont révolutionné le domaine grâce à leur mécanisme d’attention, permettant de traiter efficacement les séquences de données en parallèle. Des modèles pré-entraînés comme BERT et GPT ont ainsi atteint des performances exceptionnelles sur diverses tâches linguistiques. Avant leur émergence, les modèles récurrents (RNN), notamment les LSTM et GRU, étaient largement utilisés pour capturer les dépendances temporelles dans les données séquentielles. De plus, les modèles de Markov cachés (HMM) ont joué un rôle clé dans des applications comme la reconnaissance vocale et l’étiquetage grammatical.

Les transformeurs, comme BERT et GPT, analysent une phrase en tenant compte simultanément de toutes ses parties, ce qui améliore leur compréhension contextuelle, même dans des phrases ambiguës. Cette capacité à capturer le sens précis des mots a rendu les transformeurs incontournables dans le NLP.

Grâce à cette technologie, des applications avancées ont vu le jour. Les transformeurs sont à la base de services comme la traduction instantanée (Google Translate), la synthèse automatique de documents et les assistants virtuels tels que Siri, qui fournissent des réponses précises et contextuelles aux utilisateurs.

Pour faire du NLP, quelles sont les bases ?

Pour comprendre et s’engager efficacement dans le traitement du langage naturel (NLP), il est essentiel de posséder des bases solides dans plusieurs domaines clés. La linguistique joue un rôle fondamental, car une bonne maîtrise des structures grammaticales, de la sémantique et de la pragmatique permet de développer des modèles NLP plus précis. Par ailleurs, la programmation, en particulier avec des langages comme Python, est indispensable puisque la majorité des bibliothèques NLP sont conçues dans cet environnement.

En complément, des connaissances en statistiques, probabilités et algèbre linéaire sont cruciales pour comprendre et implémenter les algorithmes de machine learning utilisés en NLP. La maîtrise du machine learning et du deep learning est également nécessaire pour concevoir et entraîner des modèles performants, exploitant des architectures avancées comme les réseaux de neurones.

Enfin, la gestion des données est une compétence essentielle, car le succès d’un projet NLP repose sur la capacité à collecter, nettoyer et manipuler des données textuelles de manière efficace. Une bonne préparation des ensembles de données garantit la qualité et la pertinence des résultats obtenus.

L’Importance du traitement de langage naturel

Comprendre le traitement de langage naturel est devenu indispensable dans un monde où les interactions entre humains et machines sont de plus en plus fréquentes et complexes. Le NLP permet non seulement d’améliorer la communication entre les utilisateurs et les systèmes informatiques, mais aussi de tirer des insights précieux à partir de vastes quantités de données textuelles. Que ce soit pour développer des chatbots intelligents, des systèmes de recommandation, ou des outils d’analyse de sentiments, le NLP offre des solutions puissantes et innovantes.

En investissant dans la compréhension des principes fondamentaux du NLP, des modèles avancés comme les Transformers, et en se familiarisant avec les outils et les frameworks disponibles, les professionnels peuvent exploiter pleinement le potentiel de cette technologie. Le futur du NLP promet des avancées encore plus impressionnantes, avec des modèles capables de comprendre et de générer du langage de manière encore plus humaine et intuitive. Ainsi, comprendre le traitement de langage naturel ouvre des portes vers des opportunités infinies dans divers secteurs, allant de la santé à la finance, en passant par le commerce et l’éducation.

Pour ceux qui souhaitent se lancer dans le NLP, il est crucial de continuer à se former, d’expérimenter avec différents modèles et techniques, et de rester à jour avec les dernières innovations. Le NLP est un domaine en constante évolution, où la curiosité et la persévérance sont des atouts majeurs pour réussir. En fin de compte, comprendre le traitement de langage naturel ne seulement enrichit les compétences techniques, mais contribue également à créer des technologies plus intelligentes et plus humaines, façonnant ainsi l’avenir des interactions digitales.